На конференции по безопасности USENIX награду за лучший студенческий доклад получили студенты университета Карнеги-Меллона, которые представили методику автоматического детектирования уязвимых сайтов в интернете. Эта методика позволяет определить с высокой степенью вероятности, с каких сайтов начнётся распространение вредоносных программ в будущем.

Для своей работы студенты приспособили некоторые техники дата-майнинга и машинного обучения. Во время испытаний систему проверили на выборке из 444 519 сайтов, содержащих 4 916 203 страницы. Выяснилось, что найденные подозрительные сайты действительно часто подвергались взлому в течении года.

Работа студентов имеет реальную практическую ценность. Google и другие компании тратят много сил на поиск вредоносных сайтов, например, которые направляют пользователя на эксплоит-паки. Благодаря технологии SafeSearch и ей подобным браузеры предупреждают пользователя об угрозе.

Но если реализовать предложенный подход, то можно находить вредоносные сайты ещё до того, как их заразили, и предупреждать веб-мастеров.

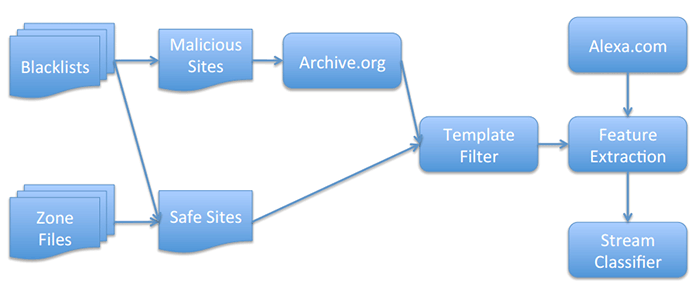

Дизайн предложенной системы предполагает анализ заражённых сайтов, автоматическое извлечение признаков (feature extraction) и поиск таких признаков на остальных сайтах.

Дизайн предложенной системы

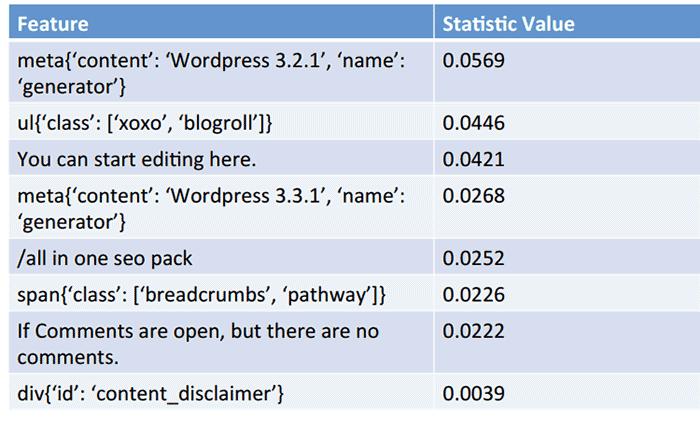

Примеры найденных признаков и их статистическая значимость