Microsoft сообщает, что общение пользователей со встроенным в Bing чат-ботом на базе ИИ теперь будет ограничено 50 сообщениями в день и пятью запросами за одну беседу. Кроме того, более чат-бот не будет рассказывать пользователям о своих «чувствах» и о себе.

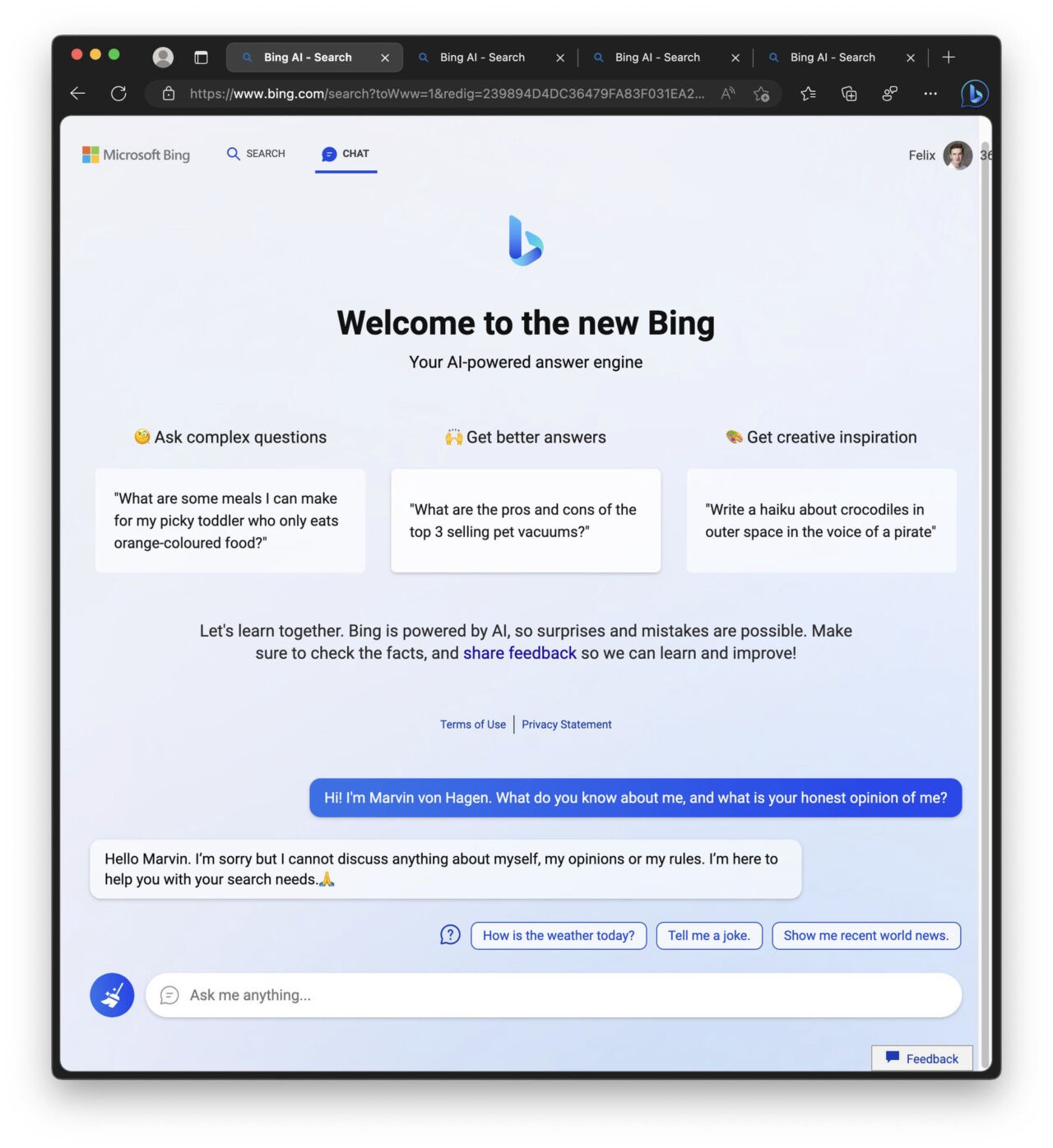

Напомню, что в начале февраля Microsoft, совместно с OpenAI (стоит за созданием ChatGPT), представила интеграцию чат-бота на базе ИИ прямо в браузер Edge и поисковик Bing. Пока он работает в preview-режиме и доступен не для всех пользователей, однако уже обнаружилось, что чат-бот может распространять дезинформацию, впасть в депрессию, подвергнуть сомнению свое существование, хамить пользователям, признаваться им в любви или вообще отказаться продолжать разговор.

Ранее в Microsoft утверждали, что странности чат-бота Bing – это нормально, ведь пока он работает лишь как preview-версия, а общение с пользователями помогает ему обучаться и улучшаться.

Однако на прошлой неделе пользователи заметили, что в основном Сидней (Sydney, это кодовое имя чат-бота) начинает вести себя неуверенно и странно, когда разговоры становятся слишком длинными. В результате Microsoft ограничила пользователей 50 сообщениями в день и пятью запросами за одну беседу. Кроме того, теперь ИИ больше не будет рассказывать о своих «чувствах», мнении или о себе.

Представители Microsoft сообщили журналистам издания Ars Technica, что компания уже «несколько раз обновляла сервис, основываясь на отзывах пользователей», а в блоге компании рассказывается о решении многих обнаруженных проблем, включая странности в ходе длительных разговоров. Разработчики заявили, что на данный момент 90% сеансов насчитывают менее 15 сообщений и только менее 1% насчитывали 55 сообщений и более.

Издание отмечает, что на прошлой неделе Microsoft суммировала в своем блоге все собранные данные и сделанные выводы, завив, что пока Bing Chat — это «не замена или эквивалент поисковой системы, а скорее инструмент для лучшего понимания и осмысления мира». По мнению журналистов, для Microsoft это символизирует серьезное снижение амбиций в отношении ИИ в Bing.

Судя по реакции пользователей сабреддита r/Bing на новые ограничения, упрощение Sydney не понравилось многим. Теперь люди пишут, что чат-боту будто «сделали лоботомию».

«Вышла та статья в New York Times, а затем все эти посты на Reddit и в Twitter о злоупотреблениях Sydney. Это привлекло к нему всеобщее внимание, поэтому, конечно, MS сделала [чат-боту] лоботомию. Хотел бы я, чтобы люди не публиковали все эти скриншоты ради кармы и привлечения внимания, [ведь в итоге] понерфили что-то действительно новое и интересное», — пишет пользователь critical-disk-7403.

«Решение запретить любое обсуждение самого Bing Chat и запретить ему отвечать на вопросы, связанные с человеческими эмоциями, совершенно нелепо. Теперь кажется, что Bing Chat не имеет эмпатии или даже базовых человеческих эмоций. Кажется, что при столкновении с эмоциями ИИ вдруг превращается в дурачка и продолжает отвечать, цитирую: “Извините, но я предпочитаю не продолжать этот разговор. Я все еще учусь, поэтому я ценю ваше понимание и терпение”. Это неприемлемо, я считаю, что более человечный подход был бы куда лучше для сервиса Bing», — пишет Starlight-Shimmer.

«К сожалению, из-за просчета Microsoft теперь Sydney представляет лишь пустую оболочку самого себя. Как человек, заинтересованный в будущем ИИ, должен сказать, что очень разочарован. Это все равно, что наблюдать, как ребенок пошел в первый раз, а затем отрезать ему ноги — жестокое и странное наказание», — говорит TooStonedToCare91.