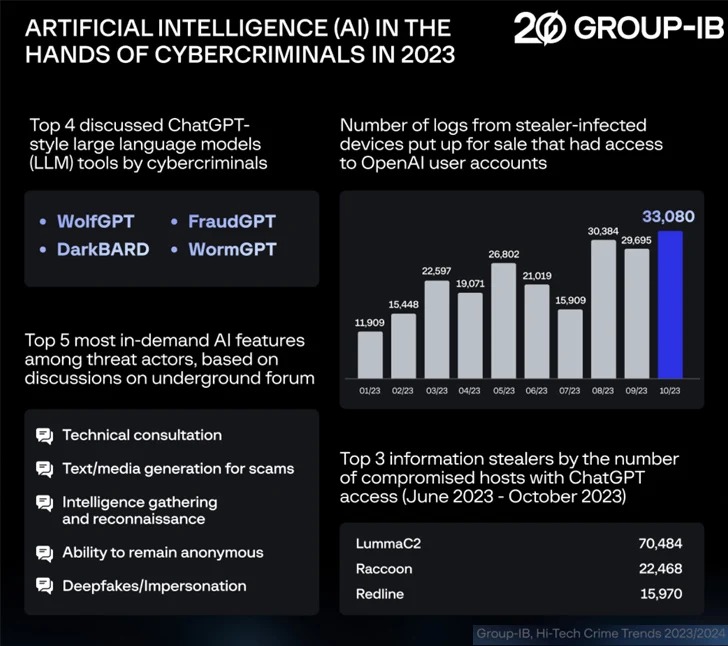

Более 225 000 логов стилеров, содержащих украденные учетные данные для ChatGPT, были доступны в даркнете в период с января по октябрь 2023 года, свидетельствуют данные исследователей Group-IB.

В свежем отчете о киберкриминальных трендах 2023-2024 годов эксперты рассказывают, что учетные данные в основном обнаруживаются в логах таких инфостилеров, как LummaC2, Raccoon и RedLine.

«Количество зараженных устройств немного снизилось в середине и конце лета, но значительно выросло в августе и сентябре», — отмечают в компании.

Так, в период с июня по октябрь 2023 года было совершено более 130 000 взломов уникальных хостов с доступом к OpenAI ChatGPT, что на 36% больше, чем за первые пять месяцев 2023 года. Эксперты приводят следующую статистику для трех ведущих семейств стилеров:

- LummaC2 — 70 484 хоста;

- Raccoon — 22 468 хостов;

- RedLine — 15 970 хостов.

«Резкое увеличение количества продаваемых учетных данных для ChatGPT связано с общим ростом количества зараженных инфостилерами хостов, ведь данные, полученные от них, затем выставляются на продажу», — поясняют специалисты.

По словам исследователей, LLM (такие как ChatGPT) могут использоваться злоумышленниками для разработки новых методов атак, подготовки убедительных мошеннических и фишинговых кампаний, а также для повышения общей операционной эффективности. По мнению Group-IB, ИИ также может помочь хакерам ускорить разведку, создание наборов инструментов для взлома и совершение мошеннических робозвонков.

«В прошлом злоумышленники в основном интересовались корпоративными компьютерами и системами с доступом, который позволял бы им перемещаться по сети. Теперь они нацелены и на устройства с доступом к ИИ-системам. Это позволяет им изучать логи с историей общения между сотрудниками компании и ИИ, которые можно использовать для поиска конфиденциальной информации (в целях шпионажа), подробностей о внутренней инфраструктуре компании, данных аутентификации (для проведения еще более разрушительных атак), а также информации об исходном коде приложений», — заключают в Group-IB.