Хакеры пользуются мощностью таких поисковых систем, как Google, для

выполнения автоматизированных атак на сайты со слабой системой защиты, заявляет

компания Imperva.

Вооруженные Google-ом, браузером и специально созданными поисковыми запросами

("Dorks"), хакеры используют ботнеты для генерирования 80 000 ежедневных

запросов. Таким образом они определяют потенциальные мишени и составляют точную

картину ресурсов в рамках уязвимого сервера, которым можно нанести урон.

При помощи автоматизации запросов и анализа результатов, злоумышленник может

выполнять большое количество поисковых запросов, изучать полученные результаты и

получать отфильтрованный список потенциальных жертв и все это за очень короткое

время и с минимальными усилиями. При этом благодаря тому, что запросы

генерируются ботнетами и не привязаны к IP хакера, хакер остается анонимным.

"Хакеры стали экспертами в области применения Google для создания карты

уязвимостей интернета. Эта киберразвездка позволяет хакерам быть более

продуктивными, когда дело доходит до конкретных атак, которые приводят к

заражению сайтов, кражам данных, модификации данных или даже проникновению на

сервера компаний", - поясняет технический директор Imperva Амачай Шульман. "Эти

атаки заставляют нас обратить внимание на то, что разработчики поисковых систем

должны делать больше, чтобы не дать возможности хакерам использовать их

платформы".

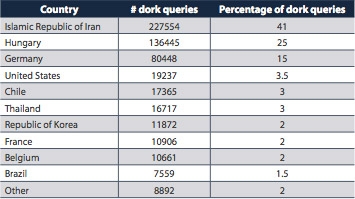

Страны-лидеры по генерированию хакерских поисковых запросов (dorks):

Чтобы заблокировать автоматизированные поисковые кампании сегодня поисковые

системы используют механизмы обнаружения, основанные на IP адресах, с которых

производится запрос. Исследование компании Imperva показывает, что хакеры с

легкостью преодолевают этот барьер путем распределения своих запросов между

различными зараженными машинами.

В течение мая и июня Application Defense Center (ADC) наблюдал за

ботнет-атакой на популярный поисковик. Для каждого уникального поискового

запроса ботнет запрашивал десятки и даже сотни страниц результатов, используя

параметры запроса.

Масштаб атаки был огромен: почти 550 000 запросов (до 81 000 в день, в

среднем 22 000 запросов) выполнилось в течение периода наблюдения. Хакер мог

воспользоваться пропускной способностью десятков контролируемых хостов в

ботнете, чтобы находить и изучать уязвимые приложения.

Разработчики поисковых систем должны создать условия для поиска необычных и

подозрительных запросов, таких, которые известны своей принадлежностью к

хакерам, которые направлены на поиск уязвимых файлов. На основе произведенного

анализа должен быть создан список IP, которые скорее всего являются частью

ботнета, а также список примеров запросов от ботнета. Используя эти "черные

списки" поисковые системы смогут:

- применить политику, направленную на блокировку автоматизированных

запросов (например, используя CAPTCHA). Google уже применяет CAPTCHA, когда

клиентский хост кажется подозрительным. Однако, похоже, что это было

мотивировано не желанием обеспечить безопасность поисковой системы, а

желанием воспрепятствовать оптимизации поисковых систем и сохранить

вычислительные ресурсы. Менее популярные поисковики редко прибегают к мерам

более серьезным, чем временные промежутки между запросами с одного и того же

IP, которые легко обойти при помощи автоматизированных ботнетов; - определить другие подозрительные хосты и занести их IP в черный список.

Также поисковые системы могут использовать черные списки IP-адресов, чтобы

предупредить зарегистрированных пользователей об опасности. Такая активная

позиция поможет сделать Интернет безопаснее, не ограничиваясь одной лишь борьбой

с зараженными хостами.