Специалисты Tencent Keen Security Lab представили масштабное исследование, посвященное взлому автомобилей Tesla. Нужно сказать, что эксперты Tencent далеко не первый раз находят и эксплуатируют уязвимости в Tesla. Например, китайские специалисты демонстрировали удаленный взлом Tesla Model S P85 и Model 75D еще в 2016 году, а в 2017 году скомпрометировали Tesla Model X, перехватив контроль над фарами и приборными панелями авто, открыв багажник и двери, а также активировав тормоза во время движения.

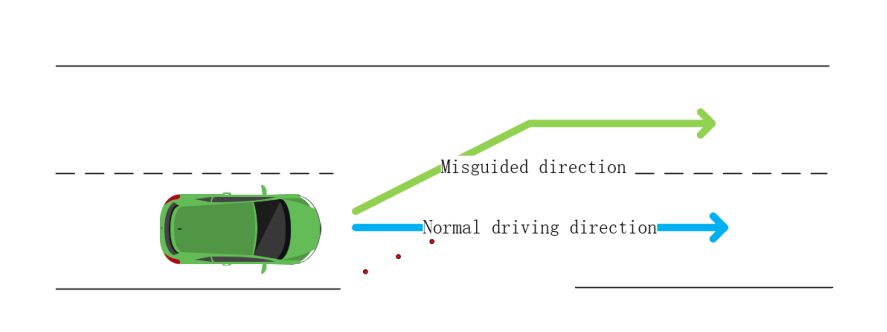

На этот раз исследователи наглядно продемонстрировали на примере Tesla Model S 75 , почему опасно полностью полагаться на систему содействия управлению автомобилем (она же адаптивный круиз-контроль или Enhanced Autopilot). Оказалось, что на дорожное покрытие достаточно нанести малозаметные для водителя «помехи», автомобиль примет их за часть дорожной разметки и, чтобы не пересекать эту несуществующую линию, свернет со своей полосы (возможно, даже на встречную).

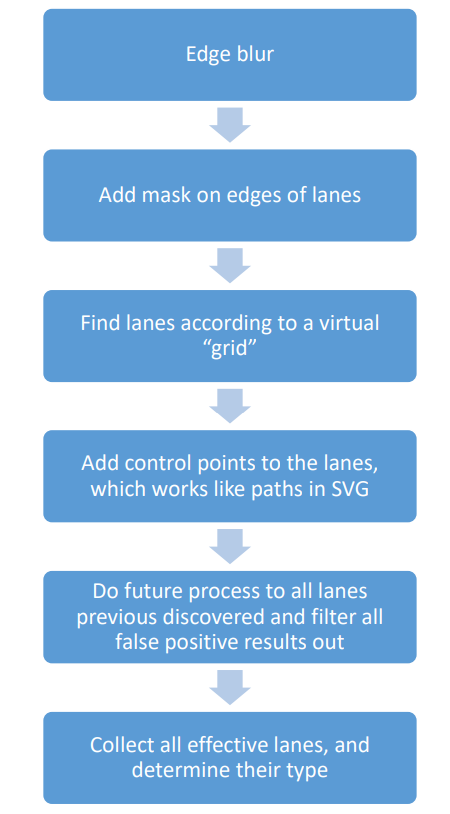

Чтобы понять, как работает технология обнаружения полос движения при включенном Autosteer, исследователи использовали железо версии 2.5 и прошивку 2018.6.1. Интересующей их функцией оказалась функция detect_and_track, которая передает многочисленные данные ядрам CUDA. Как в этот момент «думает» Tesla, показано на иллюстрации ниже. На базе этой информации автомобиль строит виртуальную карту, которая также используется для создания HD-карты в реальном времени, на которую в своей работе опираются другие компоненты авто.

В итоге специалисты решили атаковать машинное зрение авто и нейросетевые алгоритмы Tesla, использовав давно обсуждающуюся проблему состязательных примеров (adversarial examples). Речь о ситуациях, когда нейросетям намеренно поставляют искаженные данные, из-за чего у тех возникают проблемы с корректным распознаванием объектов. Правда эксперты Tencent не стали делать этого виртуально, а буквально разместили на дорожном полотне небольшие стикеры, на которые человек вряд ли обратил внимание. Их оказалось вполне достаточно для введения авто в заблуждение. В ролике ниже можно увидеть, как Tesla резко меняет полосу движения, обманувшись фальшивой разметкой экспертов.

Напомню, что похожее исследование, только связанное с «дефейсом» дорожных знаков, а не дорожной разметки, еще в 2017 году публиковала группа ученых из университетов США. Тогда эксперты тоже пришли к выводу, что беспилотные автомобили, дроны и другие подобные устройства можно довольно легко «сбить с курса».

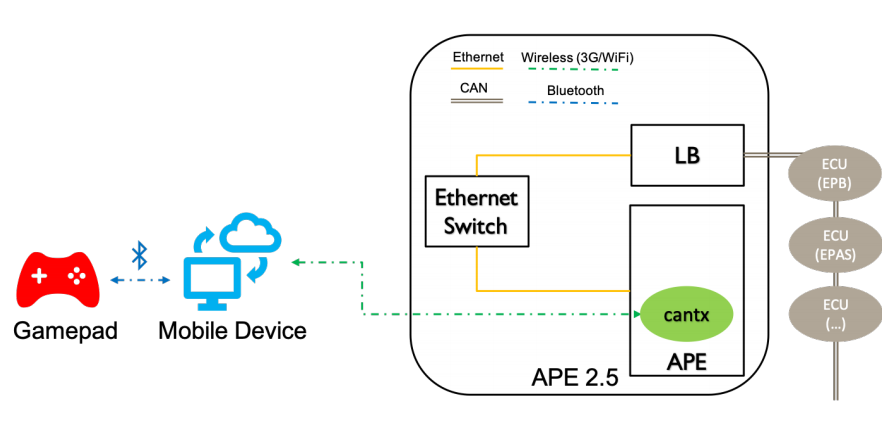

Кроме того, в отчете исследователей Tencent описаны две уязвимости, позволившие получить root-доступ к Autopilot ECU (APE), которые в настоящее время уже устранены с релизом прошивки 2018.24. С их помощью исследователи смогли перехватить управление поворотами рулевого колеса, передав контроль на обычный геймпад от игровой приставки, который был подключен к смартфону через Bluetooth.

Также специалисты сумели добиться включения стеклоочистителей в отсутствии дождя. Для этого перед автомобилем установили монитор со специальным изображением, так как в данном случае авто полагается на информацию от оптических сенсоров, и модифицированная картинка (тоже представляющая собой состязательный пример) позволила обмануть систему.

Представители Tesla уже заметили, что трюк с фальшивой разметкой вряд ли может представлять угрозу для людей в реальной жизни, ведь водитель авто в любом случае должен быть всегда готов перехватить управление у автопилота или нажать на тормоз. В свою очередь, Илон Маск в Twitter, поблагодарил исследователей за работу.

Solid work by Keen, as usual

— Elon Musk (@elonmusk) April 1, 2019