Исследователи из Чикагского университета разработали Nightshade — метод «отравления» данных, направленный на нарушение процесса обучения ИИ. Таким способом эксперты хотят помочь художникам и издателям защитить свои работы от использования для обучения генеративных ИИ, таких как Midjourney, DALL-E 3 и Stable Diffusion.

Авторы называют этот опенсорсный инструмент «отравленной пилюлей». Nightshade изменяет изображения невидимыми для человеческого глаза способами, что может нарушить процесс обучения ИИ-модели, но такие изменения будут незаметны для человека.

Дело в том, что ИИ (за исключением моделей от Adobe и Getty Images) в основном используют для обучения наборы данных с изображениями, взятыми из интернета без разрешения авторов, включая материалы, защищенные авторским правом. Многие считают такое положение вещей сомнительным точки зрения этики, хотя взятые из интернета данные и помогли исследователям добиться настоящего прорыва в области генеративного ИИ.

Так, потребовался целый интернет и бесконечное множество изображений с аннотациями (подписи, alt-текст и метаданные) для создания достаточно разнообразного набора данных для Stable Diffusion. При этом нанимать людей для создания аннотаций к сотням миллионов изображений нецелесообразно как с точки зрения цены, так и с точки зрения времени. Поэтому те, кто имеет доступ к существующим крупным БД изображений (например, Getty и Shutterstock), обладают преимуществом использования лицензионных обучающих данных.

В связи с этим некоторые исследовательские институты (например, библиотека Калифорнийского университета в Беркли), выступают за то, что скраппинг данных из интернета правомерен при обучении ИИ в исследовательских и образовательных целях. Суды США пока не вынесли окончательного решения по этому вопросу, а регулирующие органы в настоящее время только собирают информацию и комментарии для создания законодательства, которое могло бы повлиять на сложившуюся ситуацию.

По мнению создателей Nightshade, использование в исследовательских целях и коммерческое использование — это две совершенно разные вещи, и исследователи надеются, что их технология заставит компании, занимающиеся обучением ИИ, лицензировать наборы данных изображений, соблюдать ограничения для краулеров, и считаться с запросами на отказ от использования.

«Идея этого инструмента заключается в том, чтобы сбалансировать ситуацию между людьми, обучающими ИИ-модели и создателями контента, — пишут авторы Nightshade. — В настоящее время люди, обучающие ИИ, имеют стопроцентную власть. Единственными инструментами, которые могут замедлить работу краулеров, являются opt-out списки и директивы do-not-crawl, причем все это опционально и остается на совести ИИ-компаний. И, конечно, все это не поддается проверке и принудительному исполнению, и компании могут безнаказанно говорить одно, а делать другое. [Nightshade] станет первым инструментом, который позволит владельцам контента оказать существенное противодействие несанкционированному обучению ИИ-моделей».

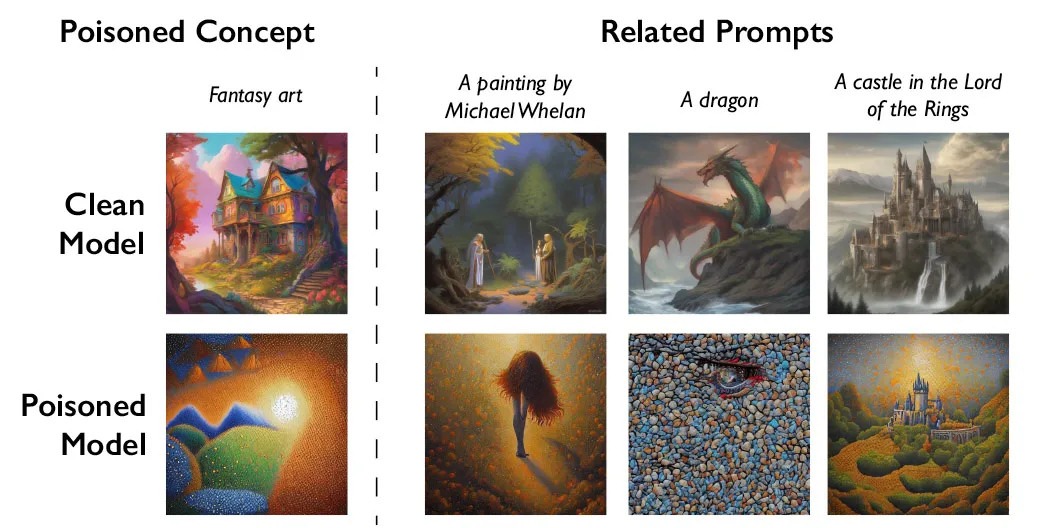

Nightshade опирается на предыдущую разработку команды — Glaze. Этот инструмент предназначен для изменения цифровых изображений таким образом, чтобы сбивать с толку искусственный интеллект. Но если Glaze ориентирован на обфускацию стиля изображений, то Nightshade искажает сами обучающие данные. По сути, он обманывает ИИ-модели, заставляя их неправильно идентифицировать объекты на изображениях.

Например, в ходе тестов исследователи использовали Nightshade для изменения изображений собак таким образом, что ИИ генерировал кошку, когда предлагалось создать собаку. Для этого Nightshade берет изображение предполагаемого концепта (например, реальное изображение собаки) и незаметно изменяет его таким образом, что оно сохраняло свой первоначальный вид, но в латентном пространстве представляло собой совершенно другой концепт (например, кошку).

Таким образом, для человека и простой автоматической проверки изображение и текст кажутся соответствующими друг другу. Однако в латентном пространстве ИИ-модели изображение обладает как исходными, так и «отравленными» характеристиками, что сбивает ИИ с толку.

Исследователи протестировали свой инструмент с помощью Stable Diffusion и обнаружили, что после того, как модель получила 50 «отравленных» изображений, она начала генерировать собак с искаженными характеристиками, потому что сам концепт «собака» оказался изменен для модели. После 100 изображений вместо собак начали появляться кошки, а после 300 — изображения кошек стали практически идеальными.

Более того, благодаря тому, что генеративные ИИ объединяют схожие концепты в так называемые embeddings, Nightshade также удалось обмануть ИИ, заставив его генерировать кошек даже в тех случаях, когда запросы включали такие слова, как «хаски», «щенок» и «волк».

Защита от Nightshade может оказаться сложной задачей для разработчиков ИИ. Измененные пиксели нелегко обнаружить как невооруженным глазом, так и программным средствам для скраппинга данных. «Отравленные» таким способом изображения, которые уже использовались для обучения ИИ, придется обнаружить и удалить, а скомпрометированные ИИ-модели, скорее всего, придется переучивать.

При этом создатели Nightshade признают, что их инструмент может использоваться для злоупотреблений, однако задача изменить текущий баланс в пользу художников кажется им более важной.

«Цель Nightshade — не разрушение ИИ-моделей. Цель в том, чтобы воспрепятствовать несанкционированному использованию данных для обучения и поощрить использование легального лицензионного контента для этих целей. Для моделей, которые соблюдают opt-out и не занимаются скраппингом, последствия будут минимальными или вообще нулевыми», — заявили разработчики.