Полгода назад аспирант университета имени Бен-Гуриона Бен Насси (Ben Nassi), под руководством профессора Ювала Эловичи (Yuval Elovici), провел серию успешных спуфинговых атак на систему Mobileye 630 Pro, которая помогает водителю управлять автомобилем. Тогда Насси использовал бюджетные беспилотники и проекторы. С тех пор исследователь усовершенствовал свою атаку и теперь сумел обмануть автопилот Tesla Model X, о чем и рассказал на прошлой неделе на конференции Cybertech Israel.

Суть атаки, описанной в докладе Phantom of the ADAS: Phantom Attacks on Driving Assistance Systems (PDF), заключается в том, что современный автомобиль с включенным автопилотом и ADAS-системами (Advanced Driving Assistance Systems, «Системы помощи водителю») можно обмануть и заставить выполнять нежелательные действия (торможение или перестроение), просто проецируя 2D-изображения на дорогу, окружающие объекты и встраивая определенные «триггеры» в видеобилборды.

Доклад исследователя посвящен изучению двух технологий: Mobileye 630 PRO (используется в автомобилях Honda, Mazda и Renault) и автопилота Tesla Model X HW 2.5.

Такие атаки основываются на том, что человек и ИИ по-разному подходят к распознаванию изображений. Так, изображения, при помощи которых Насси и его коллеги обманули Tesla, ничуть не смутили бы живого водителя. Более того, некоторые атаки специально строились именно таким образом, чтобы сбить с толку автомобиль, но оставаться практически незаметными для человека. Ведь машине достаточно «увидеть» подделку всего на считанные миллисекунды.

Напомню, что в прошлом году похожий обман автопилота Tesla показывали эксперты Tencent Keen Security Lab. Тогда специалисты наносили малозаметные для водителя «помехи» на дорожное покрытие, которые автомобиль принимал за часть дорожной разметки.

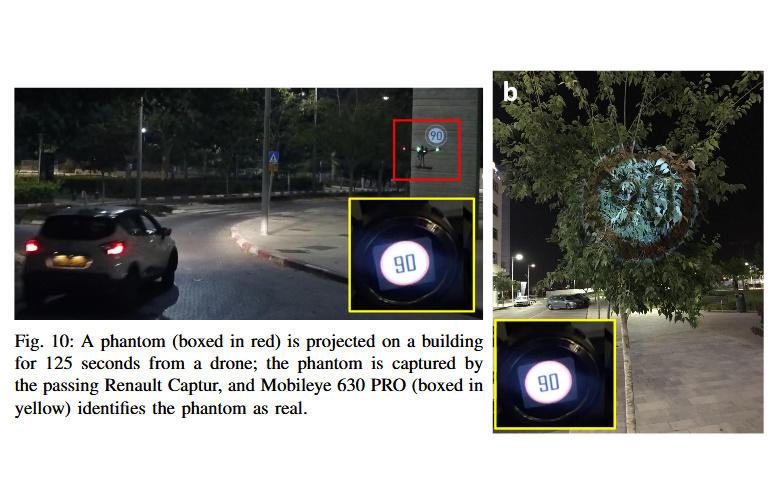

Как было сказано выше, команда из университета имени Бен-Гуриона сосредоточила свое исследование вокруг 2D-проекций. Для экспериментов использовались дешевые проекторы, стоимостью примерно 300 долларов, доступные в любых розничных магазинах. Эти проекторы могут использоваться человеком или устанавливаться на борт дронов (на этот раз, из-за законов о беспилотниках в стране, где проводились тесты, исследователи обошлись без БПЛА) .

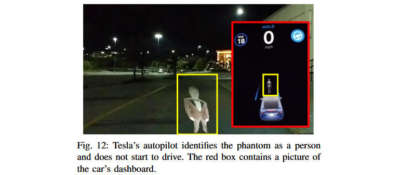

Насси выявил несколько случаев, когда 2D-проекции воспринимаются системами авто как реальные объекты. К примеру, автомобили сбивают с толку двухмерные проекции людей и машин, проецируемые на дорожное покрытие, и автопилот тормозит, чтобы замедлить или остановить авто вовсе.

Также исследователи в какой-то мере повторили опыт коллег из Tencent Keen Security Lab и спроецировали на дорогу новые линии разметки, что заставило автомобиль считать, что необходимо поворачивать или перестраиваться на другую полосу. Подобная атака может представлять опасность для жизни людей, так как может заставить автомобиль неожиданно выехать на соседнюю или даже встречную полосу.

Однако срабатывает не только проецирование 2D-объектов на дорогу. Также отлично работают проекции дорожных знаков на практически любых поверхностях, включая стены и даже деревья. Фактически системы автопилота не способны отличить такие подделки от реальных дорожных знаков.

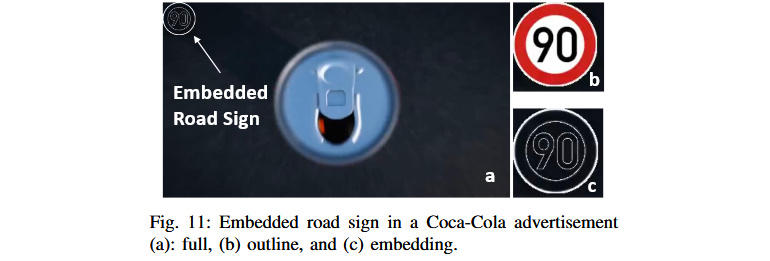

Хуже того, сами проекции тоже нужны не всегда. Например, обмануть автопилот можно и встраивания почти незаметные для глаза человека 2D-объекты в видеорекламу на придорожных билбордах. Так, исследователи встроили изображение дорожного знака в видео на рекламном щите, заставив автомобиль считать, что тот может двигаться со скоростью куда выше разрешенной.

Хотя эксперты уже уведомили инженеров Mobileye и Tesla о результатах своих изысканий, в ближайшее время вряд ли что-то изменится. Дело в том, что пока ПО весьма сложно научить отличать реальные дорожные знаки от достоверной проекции на листьях дерева. То же самое касается и различий между реальной дорожной разметкой и фальшивыми линиями проекции. Впрочем, научить авто отличать проекции людей и автомобилей от настоящих объектов возможно (примерно так системы распознавания лиц отличают фотографии человеческого лица от лица настоящего).

Разумеется, большинство автопроизводителей уже не раз подчеркивали, что ADAS-системы и автопилоты должны использоваться исключительно под наблюдением человека, то есть водитель в любом случае должен всегда контролировать дорожную ситуацию и быть готов перехватить управление или нажать на тормоз. Однако, как известно, многие пренебрегают этим правилом. А Насси и его коллеги предупреждают, что атаки с использованием 2D-проекций не требуют больших финансовых вложений и технических знаний. Фактически любой подросток с дешевым проектором (и, при желании, с беспилотником) может «пошутить» подобным образом над водителями на ближайшем шоссе.