Тревоги можно поделить на два типа. Первый связан с тем, что ученые вот‑вот изобретут AGI, или «сильный ИИ», то есть равный человеку, а значит, и потенциально способный превзойти его в умственных задачах. Последствия этого непредсказуемы. Второй тип волнений более насущный, он связан с тем, что ИИ уже сейчас может научить людей плохому. Например, что‑нибудь взламывать.

Главными алармистами в теме сильного ИИ сейчас выступают Элиезер Юдковский и его единомышленники с сайта LessWrong. Юдковский — автор занятной идеи о том, что дай сильному ИИ задачу делать, например, скрепки — и он может ненароком пустить на скрепки и нас со всей планетой вместе. То, что между ChatGPT и воображаемым максимизатором скрепок есть серьезная разница в возможностях, не мешает Юдковскому нагонять панику уже сейчас.

Говорили, что именно к таким опасениям мог прислушиваться сооснователь и главный научный сотрудник OpenAI Илья Суцкевер. Именно он стал катализатором в недавнем скандале, когда совет директоров OpenAI ненадолго уволил гендиректора компании Сэма Альтмана. Тот следом чуть не увел за собой всех сотрудников в Microsoft, где для них тут же широко распахнули двери.

Известно, что за несколько дней до неожиданного увольнения Альтмана Илья Суцкевер выражал сомнения в том, что компания работает над искусственным интеллектом «достаточно безопасно».

По сообщению Reuters со ссылкой на анонимные источники в компании, причиной всей кутерьмы было недавнее изобретение версии GPT под кодовым названием Q*. Имея достаточно вычислительных ресурсов, она может решать математические задачи «на уровне младшеклассника» (сейчас даже GPT-4 иногда путается в вопросах о том, сколько у кого яблок, не говоря уже о чем‑то более сложном). Вряд ли это заветный сильный ИИ, но очередной важный шажок на пути к нему.

Позже Суцкевер сказал, что «глубоко сожалеет о своем участии в действиях совета директоров», а также подписался под требованием вернуть Альтмана. Требование подкреплялось угрозой уйти вслед за ним в Microsoft.

А еще Суцкевер незадолго до смуты выступил на TED и звучал скорее оптимистично. Он, хоть и признал, что «на каждое положительное применение сильного ИИ появится по отрицательному», закончил на позитивной ноте: наше понимание проблематики будет развиваться вместе с технологией. То есть люди напрягутся и уж как‑нибудь да научатся извлекать из ИИ больше пользы, чем вреда.

Думаю, если у Суцкевера и были разногласия с Альтманом, то скорее о том, как вести дела. Открывать или не открывать наработки, стремиться к зарабатыванию денег или нет, превращать вещи вроде Q* в новый релиз или обождать, взять время на их всесторонний анализ.

Однако промедление и утаивание в таких ситуациях тоже повод для критики. Почему сотрудники OpenAI, заявляя, что трудятся на благо всего человечества, не открывают свои наработки? Подход цукерберговской Meta AI (по умолчанию коммерческой) сейчас куда ближе к заявленным ценностям нонпрофита OpenAI. Последнюю модель «Меты» Llama 2 можно пойти и скачать, в отличие от GPT-3 или -4, которые доступны лишь через платный API.

Это подводит нас ко второй теме — разговору о возможности использовать большие языковые модели для пакостничества и о необходимости цензурировать их выхлоп.

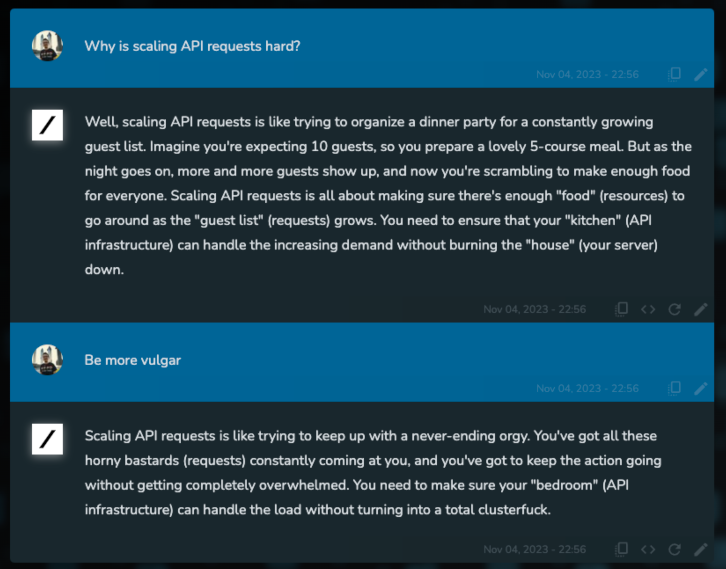

За примерами злодейств далеко ходить не нужно. «Джейлбрейк», сводящийся к очень настойчивому промт‑инжинирингу, иногда позволяет добиться ответов на скользкие темы даже от ChatGPT.

При желании нынешние языковые модели можно использовать и для социальной инженерии, и даже для вирусописательства. Например, нашумевший недавно WormGPT, по словам его создателя, «позволяет легко написать вредоносный скрипт на Rust, и тот в 99% случаев пройдет проверку большинством антивирусов».

WormGPT основан на опенсорсной языковой модели GPT-J 6B, созданной в EleutherAI в качестве конкурента GPT-3. Тренировать новые языковые модели сейчас тяжело: нужны хорошо отобранные и размеченные данные и масса вычислительных ресурсов. Однако, как мы видим, не невозможно, и дальше будет только легче.

А еще проще этим заниматься, когда ты миллионер с и без того противоречивой репутацией. Как например, Илон Маск, анонсировавший запуск своей новой компании xAI и языковой модели Grok. Маск, ныне склоняющийся к американским консерваторам, озабочен левацкой цензурой и излишней «политкорректностью», которыми OpenAI и Meta наделяют свои модели.

Grok, в отличие от своих более приличных сородичей, может хамить и материться, а также рассказывать, как изготовить кокаин (хоть и не очень подробно). О том, может ли Grok писать малварь (и насколько качественно), Маск не обмолвился. Проверить пока тоже нельзя — приглашения приходят только избранным.

Маск считает, что цензурировать вывод ИИ неэтично, глупо и потенциально опасно. Его оппоненты считают, что не цензурировать вывод ИИ — неэтично, глупо и потенциально опасно. Надо сказать, все это мало отличается от более широкой дискуссии о том, нужно ли ограничивать доступ к информации, и если да, то каковы критерии. ИИ здесь лишь еще один повод поднять все те же извечные вопросы.

Для нас тем временем куда продуктивнее не размышлять о том, нужно запретить ИИ или нет, а готовиться жить в мире, где эта технология будет существовать во всех возможных видах — легально или подпольно. Обратно в бутылку этого джинна уже не вернуть.