Группа ученых разработала атаку, которая способна помешать работе автомобилей с автопилотом, эксплуатируя их компьютерное зрение, опирающееся на камеры. В итоге авто перестают корректно распознавать дорожные знаки.

Атака получила название GhostStripe и будет детально представлена на Международной конференции ACM по мобильным системам (ACM International Conference on Mobile Systems) в следующем месяце. Пока же исследователи опубликовали доклад, согласно которому GhostStripe незаметна для человеческого глаза, но может быть крайне опасна, например, для водителей Tesla и Baidu Apollo, поскольку вмешивается в работу сенсоров, используемых в автомобилях этих марок (в частности, CMOS-сенсоров камер).

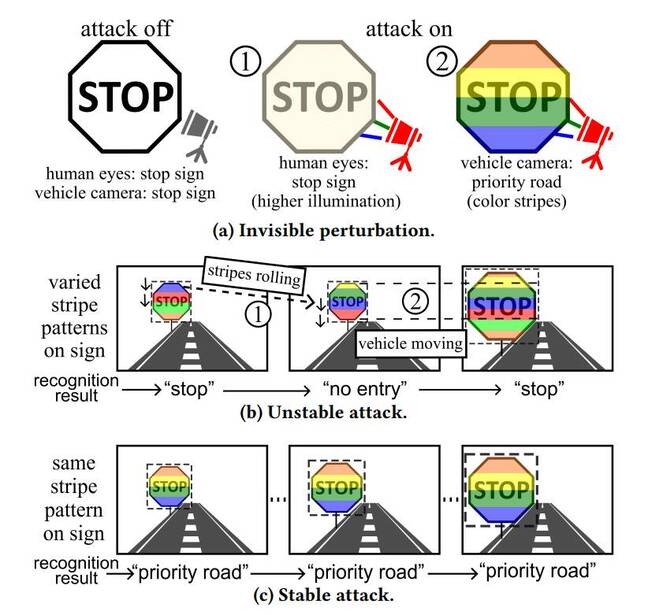

Суть атаки заключается в использовании светодиодов для освещения дорожных знаков различными световыми паттернами, чтобы ПО автомобилей не могло их распознать. Так, происходит атака на скользящий электронный затвор CMOS-сенсоров камер. Светодиоды быстро вспыхивают разными цветами на знаке. Из-за этого, например, оттенок красного на знаке «Стоп» может выглядеть по-разному для каждой линии сканирования.

В результате камера фиксирует изображение с линиями, которые вообще не соответствуют друг другу. Затем изображение обрезается и отправляется на интерпретацию классификатору в ПО автомобиля, работа которого обычно основана на нейросети. Поскольку на изображении будет множество совершенно разных линий, классификатор не распознает изображение как дорожный знак, а значит, автомобиль не станет на него реагировать.

«Для стабильной атаки необходимо тщательно контролировать мерцание светодиодов, основываясь на информации о работе камеры-жертвы, оценивая в режиме реального времени положение и размер дорожного знака в [поле зрения] камер», — пишут эксперты.

Команда разработала две версии своей атаки. Первая (GhostStripe1) даже не требует доступа к целевому автомобилю. Она использует систему мониторинга для отслеживания местоположения целевого авто в реальном времени и динамически регулирует мерцание светодиодов, чтобы знак не мог быть прочитан должным образом.

Вторая версия атаки (GhostStripe2) является таргетированной, то есть требует доступа к конкретному автомобилю. Предполагается, что получить доступ к чужой машине можно тайно, например, пока она проходит техническое обслуживание. Эта атака предполагает установку специального преобразователя на провод питания камеры для обнаружения моментов кадрирования и более точного управления таймингами.

«Таким образом, атака нацеливается на конкретный автомобиль-жертву и позволяет лучше контролировать результаты распознавания дорожных знаков», — пишут ученые.

Команда протестировала свою систему на реальной дороге и автомобиле, оснащенном камерой Leopard Imaging AR023ZWDR, которая используется в референсном образце аппаратного обеспечения Baidu Apollo. Исследователи проверили GhostStripe на знаках «Стоп», «Уступи дорогу» и «Ограничение скорости». В итоге атака GhostStripe1 сработала в 94% случаев, а GhostStripe2 — в 97%.

При этом в докладе отмечается, что яркий окружающий свет снижает эффективность атаки. «Это ухудшение происходит из-за того, что атакующий свет [светодиодов] подавляется окружающим освещением», — говорят исследователи. То есть злоумышленникам придется учитывать время и место при планировании атаки.

По словам ученых, для защиты от подобных атак проще всего заменить CMOS-камеру со скользящим затвором на датчик, который делает весь снимок сразу, или рандомизировать линейное сканирование. Кроме того, процент успеха атаки можно снизить за счет увеличения количества камер, а также GhostStripe можно включить в процесс обучения ИИ, чтобы система научилась распознавать такие проблемы и справляться с ними.