Для примера критики можно взять недавнее видео с канала Kurzgesagt, который уже много лет публикует прекрасные ролики на научно‑популярную тематику.

Авторы говорят, что изначально позитивно относились к ИИ, но теперь тревожатся: слоп заполонит интернет и (поскольку ИИ не может не косячить) найти подлинную информацию будет невозможно.

Выхлопа ИИ в интернете действительно становится все больше. К текстам и картинкам недавно добавилось видео, и TikTok уже полнится сгенерированными рилсами. Более того — вовсю идет тестирование его аналогов, где все ролики — сгенерированные. Да, пользователи о таком никогда не просили, но разве это когда‑то останавливало технические компании?

Вообще, любая достаточно революционная технология рождает страх перед неизвестностью («шок будущего», как его окрестил Тоффлер). Движимые им люди ударяются в максимализм и дружно предрекают апокалиптические сценарии. Как это бывает, прекрасно показал Олег Афонин в статье «Страшилки и ужасы ИИ», сравнив ситуацию с шорохом, который когда‑то навели электрические лампочки.

Уже даже слышно знаменитое «Подумайте о детях!». Что, если детишки насмотрятся ИИ‑слопа и... Я даже затрудняюсь сказать, что дальше. И перестанут отличать реальность от выдумки?

Да, вред от сгенерированных видео определенно возможен — только не от «слопа», а от реалистичных подделок, неотличимых от настоящих съемок. Показывая видео несуществующих событий, можно, например, пытаться управлять общественным мнением в своих интересах. Проверять пойдут далеко не все.

Подобные опасности есть у любых технологий. Не будем в очередной раз вспоминать, сколько людей гибнет от автомобилей, — это уже стало общим местом. Вокруг полно примеров того, как люди справляются с опасностями новых открытий: посмотри на розетки, например, или на газовую плиту.

Или вспомнить первых физиков‑ядерщиков, которые неизбежно облучались в ходе экспериментов. Да и не только физики! В 1920-х годах в обувных магазинах стали появляться рентгеновские аппараты для просвечивания стопы. Клиенты серьезно облучиться не успевали, а вот продавцы, работавшие с аппаратом целыми днями, получали настоящие ожоги.

Понадобилось некоторое время, прежде чем фривольное облучение рентгеном оказалось запрещено. ИИ‑слоп благодаря интернету распространяется шире и быстрее, но, по крайней мере, от него не будет рака кожи.

Человечество за свою историю научилось обращаться со множеством разных вещей — от ядовитых ягод и грибов до высокого напряжения, опасных газов, разных видов излучений и прочих чудес физики. Неужели теперь нас погубят какие‑то дерьмовые ролики в соцсетях?

Интернет давно нуждается в механизмах заверения подлинности. Тема ИИ‑слопа пришла на смену обсуждению фейкньюсов, и генеративные модели — лишь очередная технология, делающая подделки доступнее. Придумать механизм их обезвреживания — вот настоящая задача.

В X.com, например, успешно работают community notes — пометки, которыми сообщество сопровождает сомнительные высказывания (и откровенное вранье), когда такие посты распространяются слишком широко. Внутри эти пометки устроены интересным образом.

Community notes — это пример так называемого мостового механизма, или бриджинга. Соцсети давно умеют сортировать группы людей по их взглядам. Если на какую‑то информацию вдруг жалуются люди из воюющих групп, значит, перед нами точно вранье.

Это, безусловно, не панацея, и нужны новые, еще более мощные механизмы. Пример с пометками в твиттере скорее показывает, что развитие в этом направлении возможно.

Но это всё высокие материи. Недовольные слопом пользователи обычно раздражены не реализмом подделки, а наоборот: их подташнивает от сгенерированных видео, где реальность причудливо плавится. Движения людей неестественны, предметы и части тела могут исчезать и появляться, а в мелкие детали лучше не всматриваться, чтобы они не начали всматриваться в тебя. В общем, зловещая долина от края до края.

И вот тут, мне кажется, волноваться вообще не о чем. Наоборот: запомни этот период и сохраняй ролики. Будем потом показывать внукам, как смешно и убого в двадцатые годы выглядели сгенерированные видео.

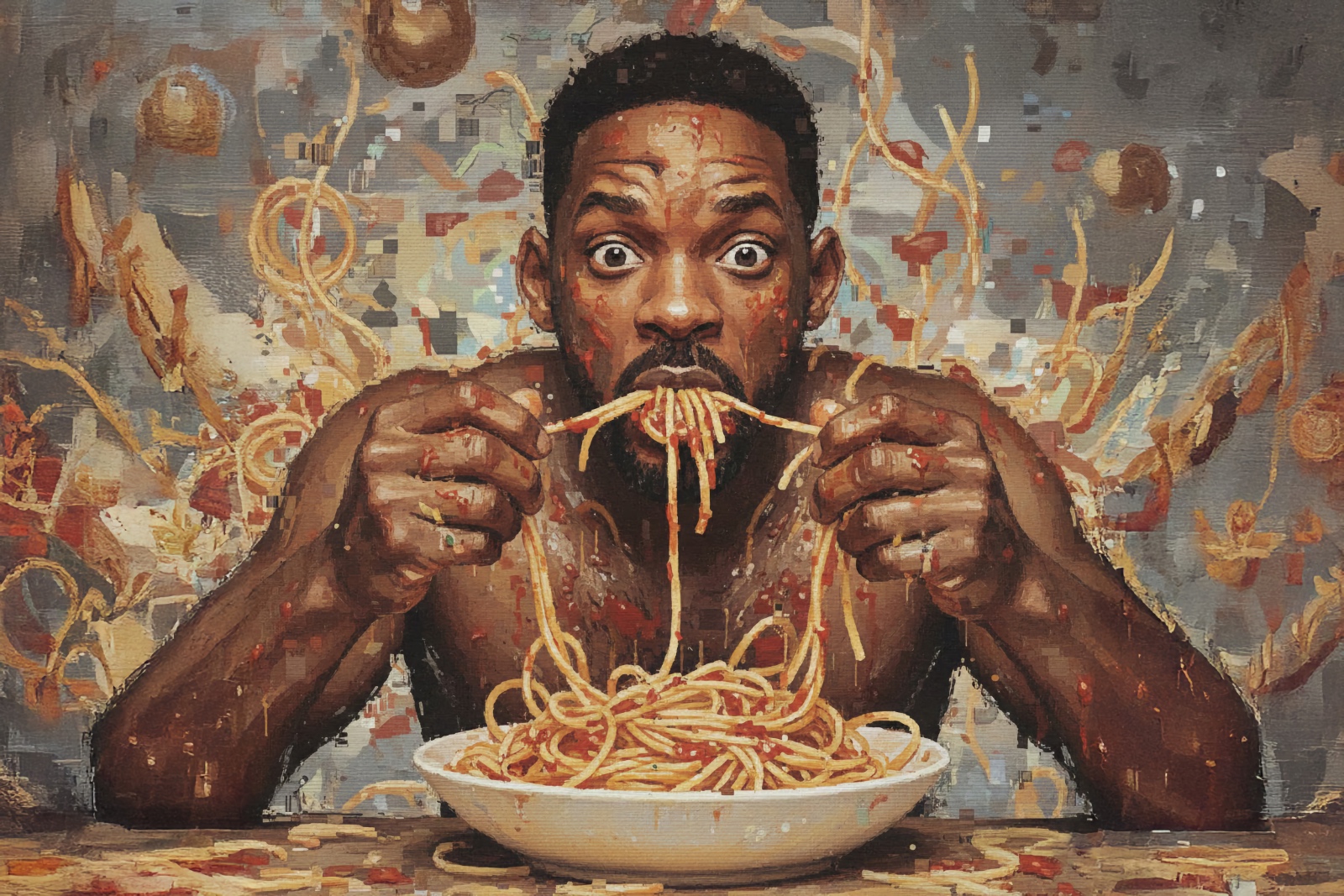

Первый ролик, где Уилл Смит поедал спагетти (точнее, сливался с ними в плавящем мозг вихре слопа), датирован мартом 2023 года. Не прошло и трех лет, и нейронки могут изобразить эту трапезу так, что не отличишь от кадров из фильма.

Да, сейчас ИИ постоянно ошибается, косячит, потом извиняется и с невозмутимым видом косячит снова. Но долго ли это продлится? Через сколько лет модели будут не глупее среднего пользователя интернета?

Возможно, и хитроумные механизмы подлинности изобретать не придется: проблема со временем сама переродится в решение.