Содержание статьи

Плюсы и минусы KVM

Проект KVM (Kernel-based Virtual Machine) в этом году празднует десятилетие. Официально он включен в ядро с версии 2.6.20, выложенное на kernel.org 4 февраля 2007 года. Изначально разрабатывался компанией Qumranet, выкупленной Red Hat в 2008 году. После сделки KVM и библиотека управления виртуализацией oVirt стала основой платформы виртуализации RHEV, поэтому Red Hat на сегодня ключевой разработчик KVM.

Технология предоставляет полную виртуализацию на аппаратном уровне. Поэтому, в отличие от популярных LXC и OpenVZ, KVM может запускать в принципе любую ОС, не только Linux (Windows, FreeBSD...), и Linux, отличающийся от конфигурации основной системы. Если нужна виртуальная машина, не совпадающая параметрами с основным хостом, то выбора особо нет. Включение в ядро было большим прорывом. Теперь поддержка виртуализации в ОС не требовала установки гипервизора (как Xen) и могла быть реализована в любом дистрибутиве, включая настольный. Из коробки доступен VNC, дающий возможность управлять виртуальным сервером с момента загрузки (то есть когда еще не работает SSH), как будто из локальной консоли. Проект активно сотрудничает с другим подобным решением QEMU, задействованы некоторые утилиты и общий формат файла образа Qcow2.

Минусы, конечно, тоже есть. Куда же без них. Главный — процессор должен иметь аппаратную поддержку виртуализации Intel VT-x или AMD-V. Проверить их наличие можно вручную или при помощи утилит:

$ sudo apt-get install cpu-checker

$ kvm-ok

INFO: /dev/kvm exists

KVM acceleration can be usedТакже о поддержке технологий говорят флаги в CPU:

$ egrep -c "svm|vmx" /proc/cpuinfoВ зависимости от производителя процессора будет загружен свой модуль ядра (kvm-amd.ko либо kvm-intel.ko).

$ lsmod | grep kvm

kvm_intel 28703 3

kvm 29690 1 kvm_intel

Накладные расходы чуть выше, чем при использовании LXC и OpenVZ. Причин тому две.

KVM-контейнер запускает свою копию ядра и окружения, и под них требуется память. LXC и OpenVZ же используют ядро и системные вызовы сервера. Поэтому при одинаковых характеристиках на хостинге у них совершенно разные возможности. При создании KVM-контейнера под него сразу резервируются все ресурсы согласно установкам. Это хорошо видно в htop. Стоит добавить ОЗУ в KVM, как сразу на это значение увеличивается объем занятой памяти. Выйти за лимиты VM не может, они устанавливаются жестко. В этом даже и плюс, можно сразу рассчитать будущую нагрузку на своем сервере, а ресурсы никто не позаимствует.

И VM работают относительно стабильно в плане производительности. В то время как при OpenVZ-виртуализации ресурсы выделяются динамически по мере надобности и каждый виртуальный сервер использует ровно столько ресурсов, сколько ему сейчас нужно. Незанятые ресурсы остаются свободными. Поэтому он и популярен у хостеров, ведь можно всегда напихать чуть больше VM, и именно поэтому виртуальные машины, созданные с запасом, могут работать то быстрее, то медленнее. Иногда оптимизация VM под OpenVZ — настоящая мука: непонятно, почему сервер стал работать по-другому — из-за новых настроек или внешних факторов.

Администрировать KVM сложнее, так как прозрачный доступ к файлам, процессам, консолям и сети контейнеров отсутствует, это приходится настраивать самостоятельно. Перестройка параметров VM в KVM (CPU, RAM, HDD) не очень удобна и требует дополнительных действий, включающих перезагрузку ОС. В том же OpenVZ это можно сделать на лету. Сам проект не предлагает удобных графических инструментов для управления виртуальными машинами, только утилиту virsh, реализующую все необходимые функции. Но, поискав в Сети, можно найти несколько интерфейсов, хотя для индивидуального использования одной или нескольких VM их обычно ставить нет смысла. К тому же много open source проектов, активно развивавшихся во время большого интереса к виртуальным машинам, сегодня стали коммерческими, хотя некоторые по-прежнему предлагают обрезанную free-версию. В репозитории пакетов есть virt-manager, предлагающий графический интерфейс для управления KVM и другими типами VM, поддерживающими virtlib, как установленных локально, так и удаленно через SSH.

$ sudo apt install virt-managerВ качестве веб-интерфейсов можно порекомендовать старенький, но еще рабочий WebVirtMgr, бесплатный UVMM UCS Core Edition, openQRM Free Community Edition и другие. Кроме того, существуют специальные дистрибутивы вроде Proxmox VE, в котором все необходимые инструменты для создания и управления VM на базе KVM и LXC уже есть (правда, он подходит для bare metal установки, а не на удаленный VDS).

Установка KVM

Плюсы KVM в том, что она работает из коробки и что процессоры серверов хостеров однозначно поддерживают эту технологию. Поэтому вполне реально при наличии свободных ресурсов подгрузить в VDS еще одну виртуальную машину (или несколько). Конечно, под фактически двойной виртуализацией они будут работать не так быстро, как на железе, но если большая нагрузка не планируется, то этого вполне должно хватить. Более того, у некоторых хостингов есть rescue-инструменты, дающие возможность подмонтировать другую файловую систему (в hetzner это rescue/LARA), подменить имеющуюся и даже установить свою ОС. При некотором умении можно по тарифам Linux абсолютно легально использовать Windows.

Наша задача — установить под KVM Win и настроить доступ. KVM работает со всеми версиями Win, включая и последние. Но Win капризней к ресурсам, поэтому тариф следует подбирать с учетом минимальных системных требований и накладных расходов на ОС и виртуализацию. На Digital Ocean, например, Win2012R2 при 4 Гбайт ОЗУ сильно тормозит, а если выделить 6+ Гбайт, то уже вполне нормальный отклик. В различных дистрибутивах и даже версиях процесс немного отличается, но в основном это касается названий пакетов. Мы будем использовать Ubuntu 16.06. Ставим пакеты.

$ sudo apt install qemu-kvm libvirt-bin ubuntu-vm-builder bridge-utilsПроверяем поддержку KVM.

$ qemu-system-x86_64 -monitor stdio -machine type=pc,accel=kvm

(qemu) info kvm

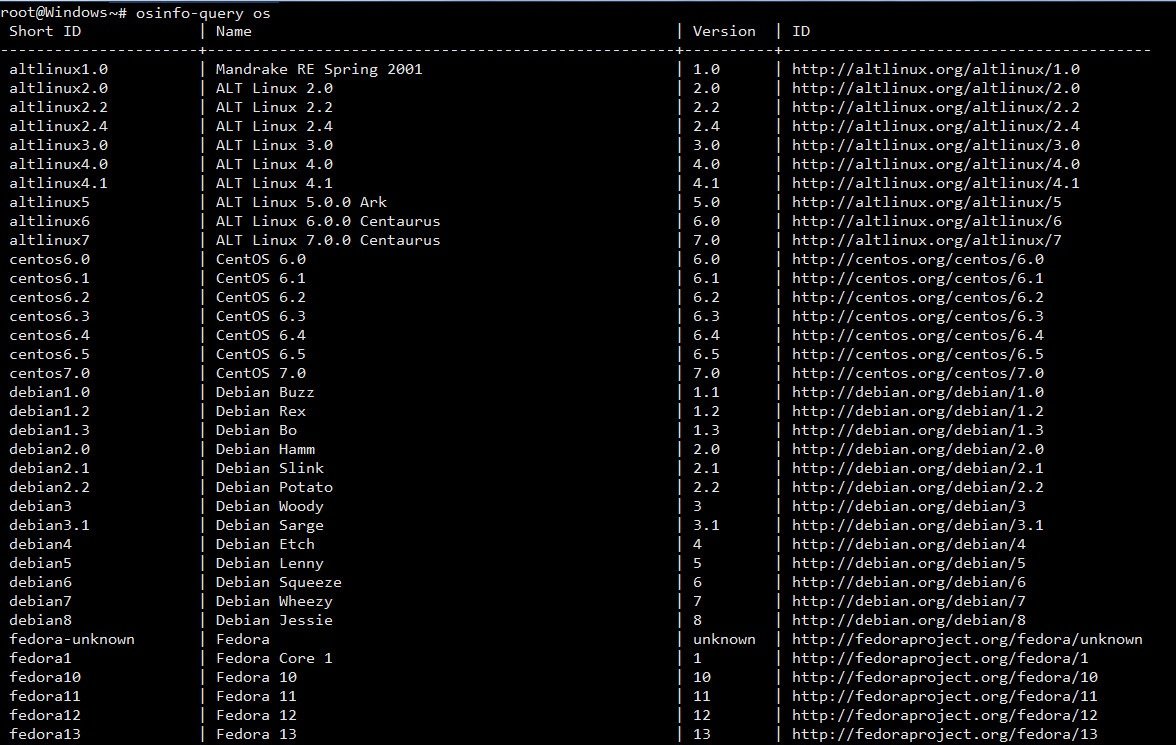

kvm support: enabledЕсли такой ответ получен, значит, все нормально. Список поддерживаемых ОС и их правильное название можно получить при помощи osinfo-query.

$ sudo apt install libosinfo-bin

$ osinfo-query osИли так:

$ sudo apt install virtinst

$ sudo virt-install --os-variant list

Конфигурационные файлы libvirt находятся в каталоге /etc/libvirt, журналы, в которых нужно искать ответы на проблемы, размещаются в /var/log/libvirt. В /var/lib/libvirt несколько каталогов: в boot система, если не указан путь, будет искать образ для установки гостевой системы, а в images размещать жесткие диски.

Управление виртуальными машинами из консоли производится при помощи утилиты virsh. Параметров много, их все можно узнать, введя:

$ virsh --helpВначале просто стоит пройтись и познакомиться, чтобы понять суть. Список ОС пока пуст:

$ virsh list --allПроверяем, что сеть настроена. По умолчанию используется default (подробнее дальше по тексту).

$ virsh net-info default

Name: default

UUID: 9a423010-a969-4e82-b91f-4b24da839c14

Active: yes

Persistent: yes

Autostart: yes

Bridge: virbr0Если в ответ получаем, что невозможно подключиться, проверяем права доступа на сокет и каталоги выше (в основном в этом проблема).

$ sudo ls -la /var/run/libvirt/libvirt-sockИ перезагружаем модули:

$ sudo rmmod kvm

$ sudo modprobe -a kvmЕще один момент. Для работы Win потребуются паравиртуальные драйверы virtio, которые реализуют работу основных устройств в виртуальном окружении. Они не обязательны, но их использование позволяет достичь большей производительности и отзывчивости в работе виртуальных окружений. Они должны поддерживаться как хостом, так и гостевой ОС. В ядре Linux драйвер поддерживается с 2.6.25, но модуль по умолчанию не ставится. Если вызов /sbin/lsmod | grep virtio и cat "/boot/config-uname -r" | grep -i virtio ничего не показал, следует установить пакет qemu-guest-agent. Для гостевой ОС ISO-образ доступен на fedoraproject.org.

$ wget https://fedorapeople.org/groups/virt/virtio-win/direct-downloads/stable-virtio/virtio-win.isoДалее два варианта. Можно самостоятельно установить операционную систему или взять уже готовый образ с установленной ОС. Первый шаг в общем отличается тем, что нужно подготовить диск, запустить VM и установить ОС стандартным способом. Создадим диск размером 25 Гбайт.

$ qemu-img create -f qcow2 -o preallocation=metadata winserv2012.qcow2 25G

Formatting 'winserv2012.qcow2', fmt=qcow2 size=26843545600 encryption=off cluster_size=65536 preallocation=metadata lazy_refcounts=off refcount_bits=16Если в будущем нужно изменить размер диска, то используется команда resize:

$ qemu-img resize winserv2012.qcow2 +10GСтавим ОС:

$ virt-install --connect qemu:///system --name WinServ2012 --ram 6048 --vcpus 4 --disk path=winserv2012.qcow2,format=qcow2,bus=virtio,cache=none --disk path=virtio-win.iso,device=cdrom --cdrom win2012.iso --network=bridge:virbr0,model=e1000 --vnc --os-type=windows --os-variant=win2k12r2 --noautoconsole --accelerate --noapic --keymap=en-usНекоторые параметры очевидны, поэтому кратко:

- name — имя, по которому можно обращаться к VM;

- ram и vcpus — количество памяти и vCPU, выделяемых VM;

- disk — имя диска, формат и драйвер;

- cdrom — виртуальный CD-ROM, здесь указан ISO-образ, с которого будет загружаться система;

- network — сетевое подключение, тип и модель (можно использовать virtio, но бывают проблемы, потом можно сменить);

- os-type и os-variant — тип ОС.

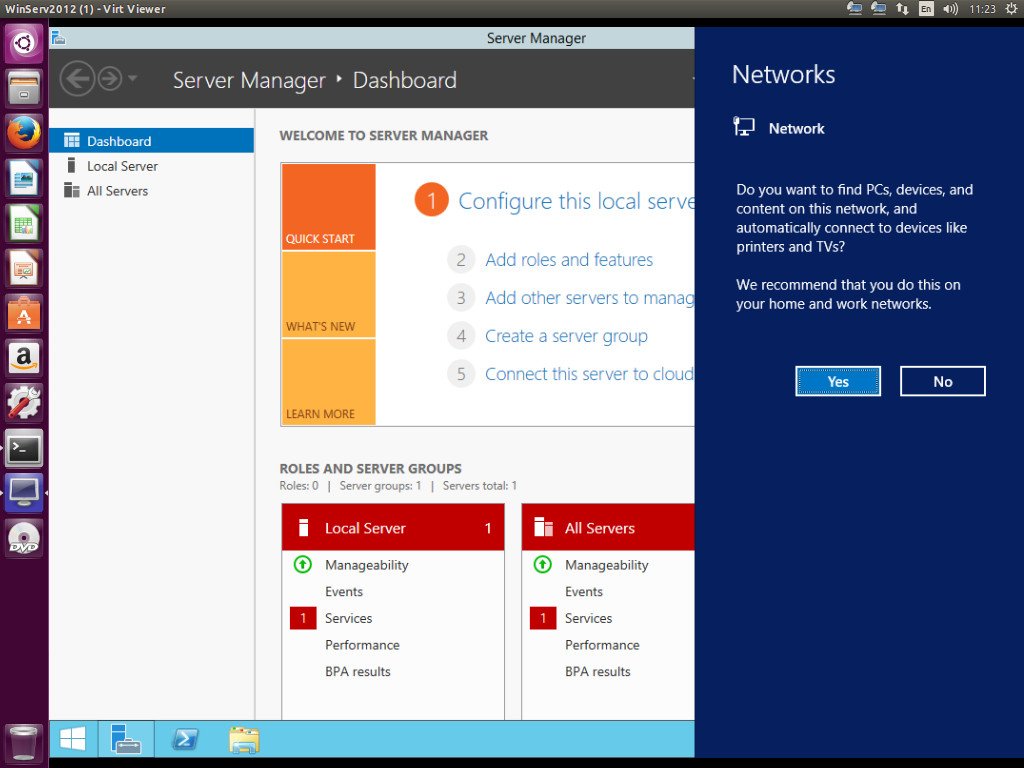

Параметр --vnc имеет смысл только на сервере без GUI, при наличии интерфейса KVM сразу откроет окно через SDL. Также можно подключиться локально при помощи virsh:

$ virsh --connect qemu:///system start WinServ2012или удаленно:

$ virt-viewer -c qemu+ssh://example.org/system WinServ2012Удаленно также можно зайти с использованием любого VNC-клиента, при необходимости используя port forwarding (см. ниже).

После установки ОС можно приступать к работе. Второй вариант позволяет использовать уже готовый диск с установленной ОС. Его можно скопировать с готовой системы, сконвертировать при помощи qemu-img convert, которая поддерживает форматы дисков практически всех систем виртуализации. Или взять с сайта проекта Cloudbase.

Запуск почти не отличается от предыдущего, убираем, если не нужен, cdrom и добавляем --import.

$ virt-install --connect qemu:///system --name WinServ2012R2 --ram 6048 --vcpus 4 --disk path=win2012r2.qcow2,format=qcow2,bus=virtio,cache=none --network=bridge:virbr0,model==virtio --vnc --os-type=windows --os-variant=win2k12r2 --noautoconsole --accelerate --noapic --keymap=en-us --importВ дальнейшем можно управлять поведением VM при помощи virsh start|reboot|shutdown|suspend|resume|destroy|undefine|edit|autostart|info и так далее.

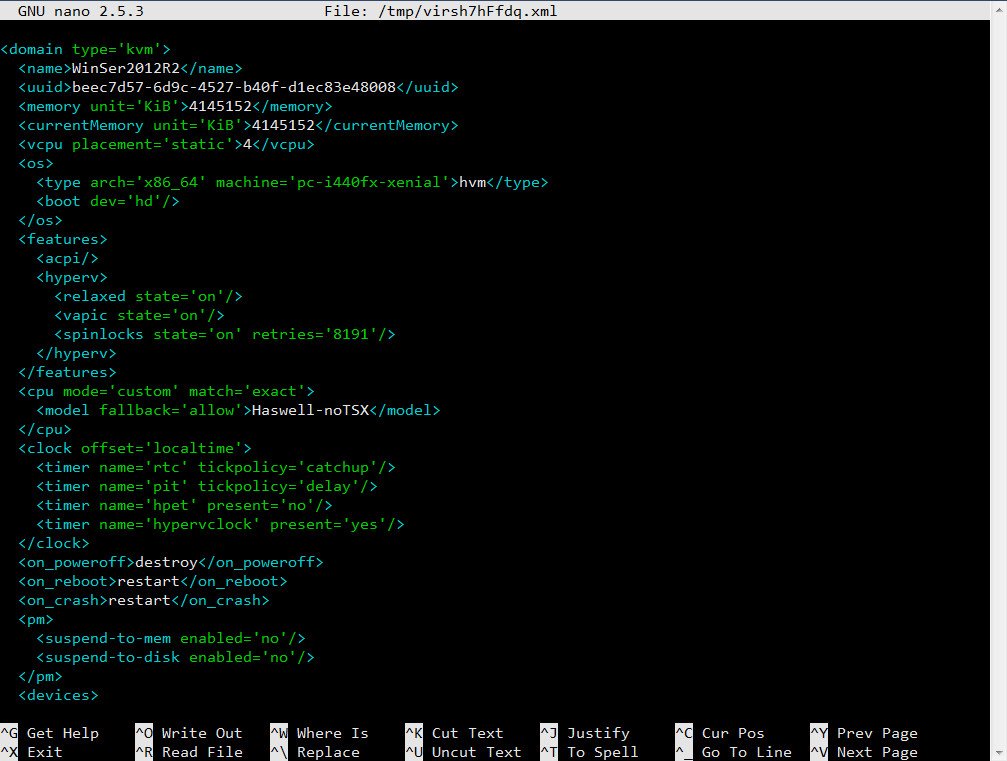

$ virsh suspend WinServ2012R2Настройки VM хранятся в отдельных XML-файлах в каталоге /etc/libvirt/qemu, имя соответствует параметру --name. Можно их просмотреть, отредактировать при необходимости, скопировать при помощи virsh. Например, нужно изменить настройки сетевого адаптера.

$ virsh edit WinServ2012R2

...

Скопируем настройки в файл.

$ virsh dumpxml WinServ2012R2 > WinServ2012R2-clone.xmlТеперь в любом текстовом редакторе правим параметры второй машины, указываем новый виртуальный диск и можем запускать второй экземпляр. Для клонирования есть и другой вариант.

$ virt-clone -o WinServ2012R2 -n WinServ2012R2-clone --file /var/lib/libvirt/images/WinServ2012R2-clone.qcow2

Сеть в KVM

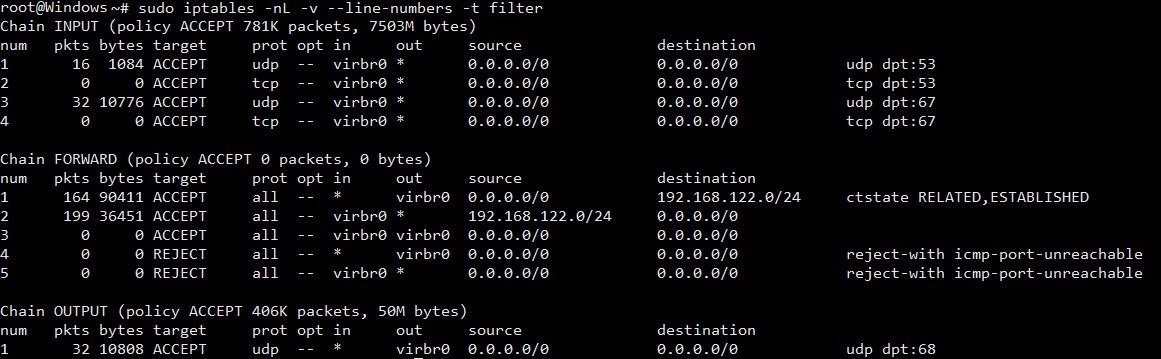

Настройка сети — самый важный момент при работе с KVM. По умолчанию используется Usermode или default, когда базовая система работает как маршрутизатор между внешней и гостевой сетью. Гостевая ОС может получать доступ к внешним сетевым сервисам, но не видна из сети. IP выбирается автоматически при помощи DHCP из диапазона 192.168.122.0/24, интерфейс основной ОС всегда имеет IP 192.168.122.1. Для доступа к сервисам нужно самостоятельно настроить маршрутизацию. После установки libvirtd должен создать ряд NAT-правил iptables.

$ sudo iptables -n -t nat -L

Второй вариант — Bridged, когда интерфейс гостевой ОС привязывается к физическому интерфейсу и VM доступна извне без допнастроек. Этот вариант чуть сложнее в настройках, так как из-за перестроек можно потерять SSH-подключение. Поэтому при отсутствии локальной консоли (Java/веб-аплета у провайдера) пользоваться им нужно только после тщательного тестирования, и мы его рассматривать не будем.

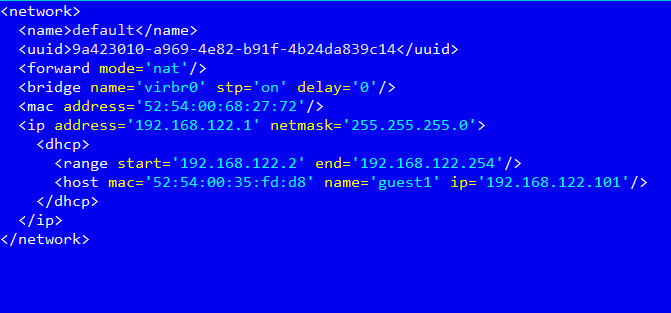

В первом варианте удобнее настроить KVM так, чтобы она назначала гостевой системе один и тот же IP-адрес. Это можно сделать прямо в конфигурационном файле /etc/libvirt/qemu/networks/default.xml или вызвав

$ sudo virsh net-edit defaultДалее добавляем параметр host в секции dhcp:

И так для каждого узла. После чего перезапускаем сеть.

$ sudo virsh net-destroy default

$ sudo virsh net-start defaultТеперь можем указать маршрут к сервису в основной системе:

iptables -t nat -A PREROUTING -p tcp -d 1.2.3.4 --dport 3389 -j DNAT --to-destination 192.168.122.2По умолчанию VNC в хостовой машине слушает только локальный порт. Поэтому при подключении с помощью VNC-клиента нужно обязательно пробрасывать порты.

$ ssh user@example.org -L 5900:127.0.0.1:5900Изменить эту ситуацию можно несколькими способами: добавив параметр --vnc,listen=0.0.0.0 и при необходимости указав другой порт --vncport 5901.

$ netstat -ant | grep 5900

tcp 0 0 0.0.0.0:5900 0.0.0.0:* LISTENАналогичные настройки есть в сетевых установках хоста.

Чтобы не менять установки для каждой VM, проще изменить это поведение глобально:

$ sudo nano /etc/libvirt/qemu.conf

vnc_listen = "0.0.0.0"

# Пароль не более восьми символов

vnc_password = "password"Заключение

Ну вот, собственно, мы имеем Windows, запущенную внутри Linux. Конечно, рассматривать KVM для локальной установки, где сильны позиции у VirtualBox и VMware Workstation, не стоит, но при наличии свободных ресурсов на VDS можно быстро развернуть еще одну машину. Скорость, конечно, будет невелика, но для небольших тестов вполне достаточная.