Ранее на этой неделе известный криптограф и профессор университета Джонса Хопкинса Мэтью Грин (Matthew Green) сообщил в Twitter, что компания Apple скоро начнет искать среди пользовательских изображений признаки сексуального насилия над детьми. В длинном треде эксперт рассказывал, что «это очень плохая идея», которая впоследствии может стать «ключевым элементом для создания системы наблюдения для зашифрованными сообщениями».

I’ve had independent confirmation from multiple people that Apple is releasing a client-side tool for CSAM scanning tomorrow. This is a really bad idea.

— Matthew Green (@matthew_d_green) August 4, 2021

Regardless of what Apple’s long term plans are, they’ve sent a very clear signal. In their (very influential) opinion, it is safe to build systems that scan users’ phones for prohibited content.

— Matthew Green (@matthew_d_green) August 5, 2021

That’s the message they’re sending to governments, competing services, China, you.

Грин предполагал, что компания будет использовать хеши изображений, что может спасти конфиденциальность пользователей, но не убережет их от ложных срабатываний и даже намеренных злоупотреблений (в частности, эксперт опасается, что в странах с авторитарным режимом эта система может использоваться отнюдь не для защиты детей). К тому же Грин писал, что сканирование будет осуществляться с помощью нового проприетарного инструмента Apple, о котором пока известно крайне мало.

These images are from an investigation using much simpler hash function than the new one Apple’s developing. They show how machine learning can be used to find such collisions. https://t.co/N4sIGciGZj

— Matthew Green (@matthew_d_green) August 5, 2021

Теперь информация Мэтью Грина практически полностью подтвердилась, и компания Apple официально анонсировала новую функциональность.

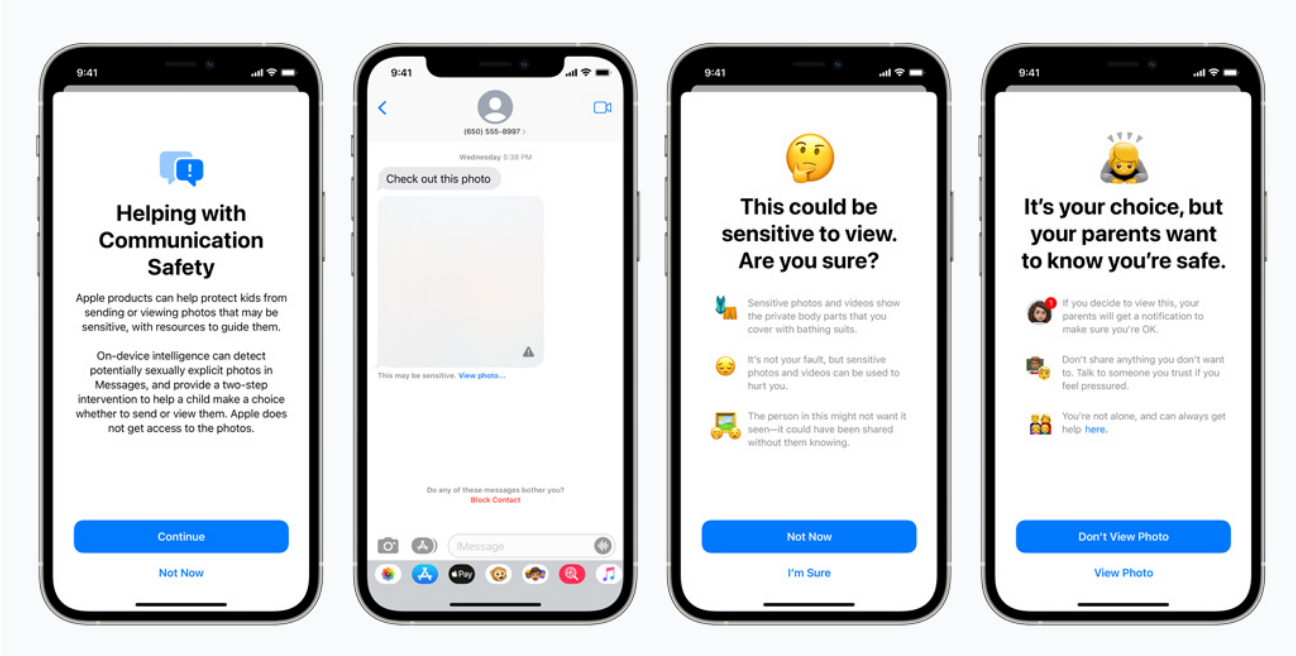

Для начала Apple будет проверять все сообщения Messages, полученные и отправленные детьми, в поисках наготы. Также Apple обновит Siri и Search, чтобы «предоставить родителям и детям расширенную информацию и помощь, если они столкнутся с небезопасными ситуациями». Так, скоро Siri и Search будут «вмешиваться, когда пользователи выполняют поиск по запросам, связанным с CSAM [child sexual abuse materials; англ. материалы, содержащие признаки сексуального насилия над детьми]», и «объяснят пользователям, что интерес к этой теме вреден и проблематичен, а также предоставят ссылки на ресурсы партнеров для получения помощи в решении этой проблемы».

Проверять будут и изображения в iCloud Photos, а обнаруживая там противоправный контент, Apple сможет «предоставлять правоохранительным органам ценную и полезную информацию о распространении известных CSAM».

Обновление будет распространяться на семейные аккаунты iCloud для iOS15, iPad OS15 и macOS Monterey. И, как оказалось, для поиска порнографии будут использоваться не хеши изображений, а специальный инструмент на основе нейронной сети.

«Насколько я знаю, [этот инструмент] использует новую “функцию нейронного сопоставления” и он обучался на базе изображений сексуального насилия над детьми, [предоставленной Национальным центром США по делам пропавших без вести и эксплуатируемых детей]. Поэтому я ошибался, говоря, что это хеши. Это намного мощнее, — комментирует Грин. — Я не знаю, что именно делает эта нейронная сеть: может ли она обнаруживать новый контент, который выглядит как сексуальное насилие, или просто распознает точные совпадения?».

«Messages используют машинное обучение на устройстве для анализа вложенных изображений и определения того, содержит ли фото изображение порнографического характера. Эта функция разработана таким образом, что Apple не имеет доступа к сообщениям, — гласит официальная документация Apple. — Вместо сканирования изображений в облаке система выполняет сопоставление на устройстве [пользователя], с использованием базы данных известных хешей CSAM, предоставленных NCMEC (Национальным центром США по делам пропавших без вести и эксплуатируемых детей) и другими организациями, занимающимися безопасностью детей. Apple преобразует эту базу данных в нечитаемый набор хешей, который будет надежно храниться на устройствах пользователей».

Если какое-либо изображение будет признано слишком откровенным, iPhone сам размоет фотографию, а ребенок будет предупрежден об этом. Также система может уведомить родителей ребенка, если ребенок все же решит просмотреть полученное от кого-то изображение или попытается отправить кому-то откровенные фото.

«Это невероятно мощная демонстрация технологии, показывающая, что даже защищенные сквозным шифрованием фотографии можно подвергать сложному сканированию. Само сканирование является безвредным, и при обнаружении [откровенных] изображений будет уведомлен только родитель пострадавшего. Но это демонстрирует, что Apple готова создать и развернуть такую технологию. Я надеюсь, что их никогда не попросят использовать ее для других целей», — резюмирует Мэтью Грин.

«Apple подменяет стандартную для отрасли систему E2E-шифрования для обмена сообщениями инфраструктурой для наблюдения и цензуры, которая будет уязвима для злоупотреблений и расширений не только в США, но и во всем мире. Apple следует отказаться от этих изменений и восстановить веру пользователей в безопасность и целостность данных на устройствах и в сервисах Apple», — пишет глава Center for Democracy & Technology's Security & Surveillance Project Грег Ноджим (Greg Nojeim), отмечая, что сканирование изображений из зашифрованных сообщений, это самый настоящий бэкдор.

Похожее мнение в свежей статье выражают и специалисты «Фонда электронных рубежей» (Electronic Frontier Foundation, EFF), которые пишут, что «Apple планирует встроить бэкдор в свою систему хранения данных и систему обмена сообщениями».

«Apple может подробно объяснять, как техническая имплементация [данной технологии] сохранит конфиденциальность и безопасность в ее предлагаемом бэкдоре, но в конечном итоге даже тщательно задокументированный, продуманный и строго ограниченный бэкдор по-прежнему остается бэкдором. Сказать, что мы разочарованы планами Apple, не сказать ничего. — пишут представители EFF. — Мы говорили об этом ранее и скажем вновь: невозможно создать систему сканирования на стороне клиента, которая могла бы использоваться только для поиска изображений сексуального характера, отправленных или полученных детьми. Как следствие, даже благие намерения по созданию такой системы нарушат ключевые принципы шифрования мессенджера и открывают двери для более широких злоупотреблений.

Это просто не скользкая дорожка, это полностью готовая система, которая ждет, когда внешнее давление внесет в нее небольшие изменения. Возьмем пример Индии, где недавно принятые правила содержат опасные требования: платформы обязаны определять происхождение сообщений и осуществлять предварительную проверку контента. Или к сервисам для обмена сообщениями могут применяться новые законы Эфиопии, которые требуют удаления “дезинформации” в течение 24 часов. И многие другие страны (часто с авторитарными правительствами) уже приняли аналогичные законы.

Нововведения Apple делают возможными такие проверки, удаления и жалобы для сообщений, защищенных сквозным шифрованием. Случаи злоупотреблений легко представить: правительства, запрещающие гомосексуализм, могут потребовать, чтобы классификатор был обучен ограничивать очевидный контент ЛГБТК +, или авторитарный режим может потребовать, чтобы классификатор мог обнаруживать популярные сатирические изображения или протестные брошюры».

Как это работает?

Техническое описание Apple гласит, что компания «ничего не узнает об изображениях, которые не соответствуют известной базе данных CSAM (child sexual abuse materials; англ. материалы, содержащие признаки сексуального насилия над детьми).

«Apple не может получить доступ к метаданным или визуальным производным для совпадающих изображений CSAM, пока не будет превышен порог совпадений для учетной записи iCloud Photos».

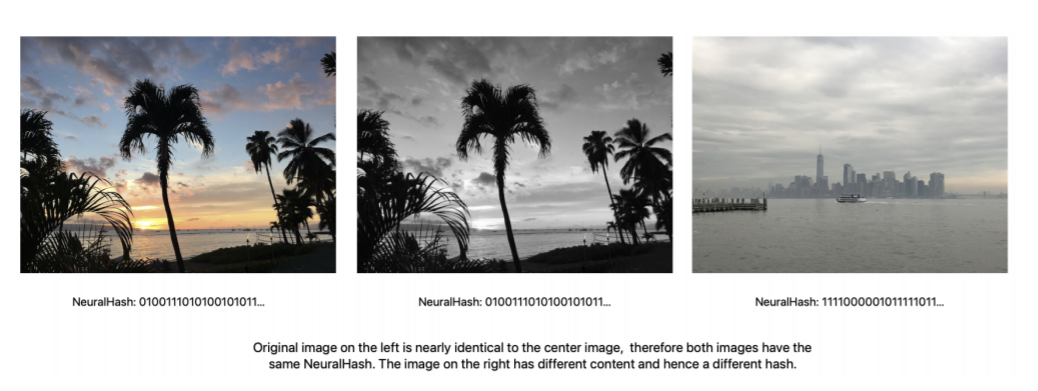

Сама технология носит название NeuralHash. Сообщается, что она «анализирует изображение и преобразует его в уникальный номер, соответствующий этому изображению. Только другое изображение, которое выглядит почти идентичным, может дать такое же число; например, изображения, которые отличаются по размеру или качеству перекодирования, по-прежнему будут иметь одинаковое значение NeuralHash».

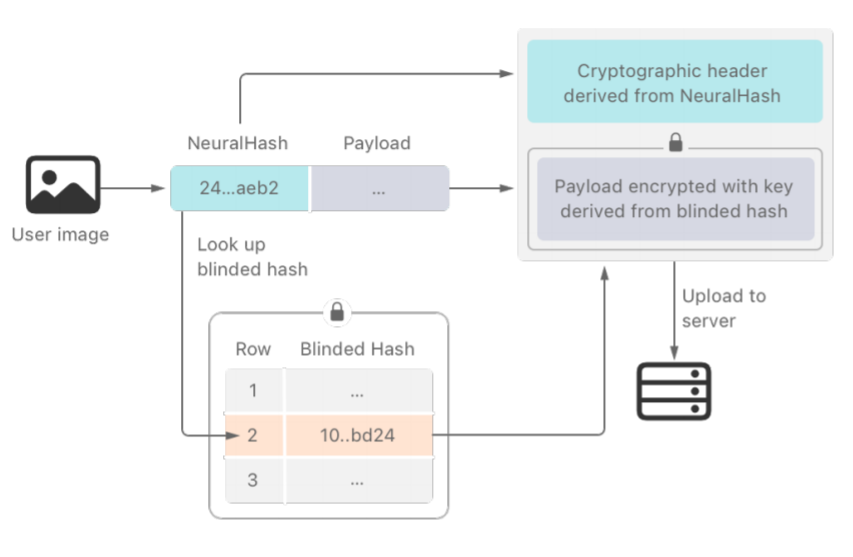

Прежде чем iPhone или другое устройство Apple загрузит изображение в iCloud, «устройство создаст специальный ваучер криптографической безопасности, где будут закодированы результаты совпадения. Также будут зашифрованы NeuralHash изображения и его визуальная производная. Этот ваучер будет загружен в iCloud Photos вместе с изображением».

Документация гласит, что содержимое ваучера не может быть интерпретировано Apple, если только учетная запись iCloud Photos не превысила пороговое значение по известному содержимому CSAM.

При этом Apple уверяет, что может гарантировать менее одного ложноположительного срабатывания на один триллион проверок в год для каждой учетной записи. Также Apple якобы «вручную проверяет все отчеты, отправленные в NCMEC, чтобы гарантировать точность». В худшем случае пользователи смогут «подать апелляцию на восстановление своей учетной записи».

Пользовательские устройства будут хранить «слепую базу данных», которая позволит устройству определять, совпадает ли фотография с изображением в базе CSAM.

«Apple получает NeuralHashes, соответствующие известным CSAM, от организаций по защите детей. Затем эти NeuralHashes проходят серию преобразований, в том числе заключительный этап сокрытия, основанный на криптографии с эллиптическими кривыми. Сокрытие выполняется с использованием секрета на стороне сервера, известного только Apple. Скрытые хэши CSAM помещаются в хеш-таблицу, положение в которое является функцией NeuralHash изображения CSAM. Эта база данных надежно хранится на устройствах пользователей. Криптография на основе эллиптических кривых гарантируют, что ни одно устройство не сможет сделать никаких выводов из этой слепой базы данных о лежащих в основе хэше изображениях CSAM».

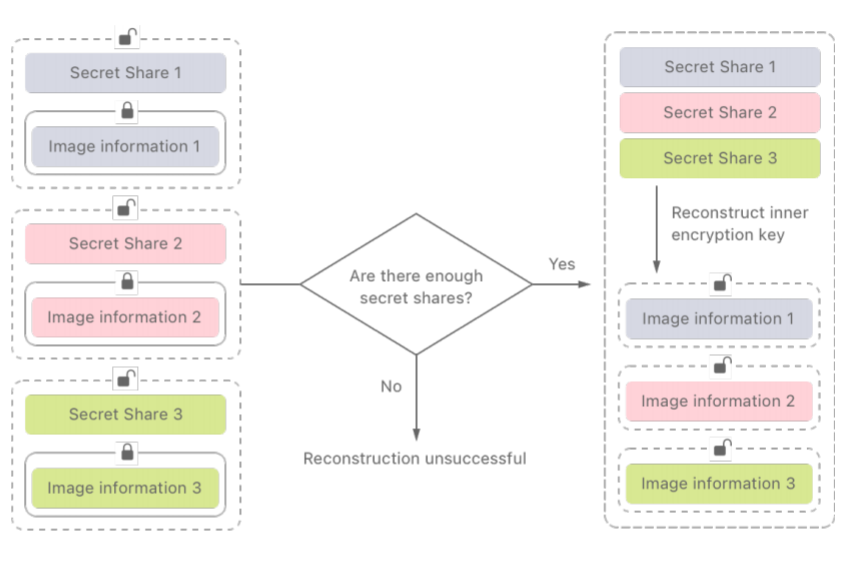

Результаты таких проверок получает Apple, но они не могут быть прочитаны сами по себе. Здесь Apple применяет другой криптографический принцип, называемый пороговым разделением секрета, который позволяет расшифровать содержимое лишь в том случае, если пользователь превысил пороговое значение известных CSAM-изображений.

Apple не конкретизирует, о каких пороговых значениях идет речь. Но, например, что если секрет разделен на тысячу частей, а порог составляет десять CSAM-изображений, секрет может быть восстановлен из любого из этих десяти изображений.

После этого Apple получает возможность расшифровать совпадающие изображения, вручную проверить их содержимое, заблокировать учетную запись пользователя и предоставить изображения в NCMEC, откуда информацию передадут правоохранительным органам.

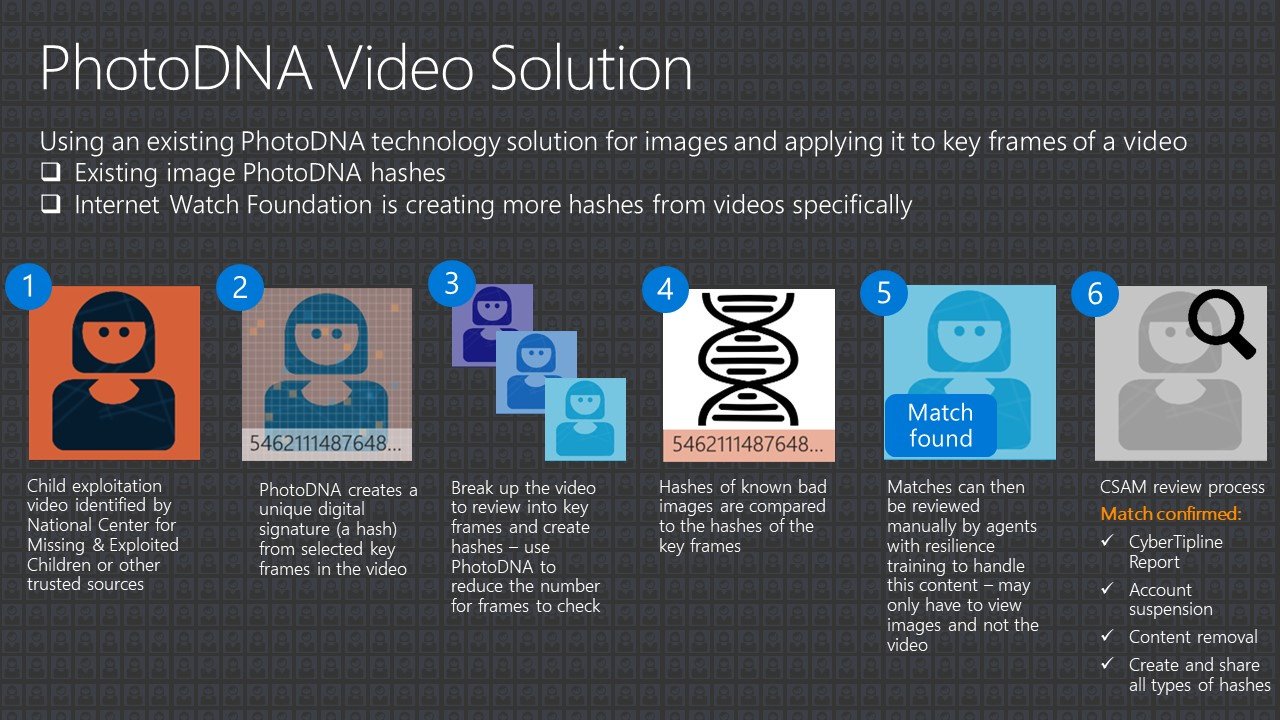

PhotoDNA

Нельзя не сказать о том, что похожие системы обнаружения противоправного контента давно используют другие компании. К примеру, еще в 2009 году компания Microsoft создала решение под названием PhotoDNA,призванное бороться с распространением детской порнографии в интернете. PhotoDNA сравнивает изображения с обширной коллекцией известных хешей изображений CSAM, предоставленных NCMEC. Эту технология до сих пор применяется довольно широко, ее использует сама Microsoft (в том числе в Bing и OneDrive), Google, Gmail, Twitter, Facebook, Adobe, Reddit, Discord и сотни других компаний.

Также в использовании PhotoDNA давно подозревают и компанию Dropbox (которая не подтверждает, но и не опровергает этого). Дело в том, что компания не раз помогала правоохранительным органам обнаруживать педофилов, и честно заявляет, что может проверять файлы пользователей на соответствие Acceptable Use Policy и Terms of service.

При этом в своем недавнем послании представители EFF напоминали, что одна из таких систем уже была перепрофилирована для борьбы с терроризмом, но на деле проверить точность и прозрачность ее работы не может никто. Также они вспоминают проблемы в работе аналогичных систем, которые возникали в социальной сети Tumblr, где алгоритмы принимали за порнографию фотографии щенков померанского шпица, селфи полностью одетых людей и многое другое, и Facbook, где автоматика удаляла фотографий известных статуй, включая Русалочку в порту Копенгагена.

Однако существенное отличие PhotoDNA от нововведений Apple заключается в том, что компании изучают файлы пользователей в облаке, на своих серверах, но не на пользовательских устройствах, а также работа этих систем не затрагивает острые вопросы E2E-шифрования.

Как уже было сказано выше, многие ИБ-специалисты приравняли новую технологию к бэкдору, подвергнув Apple жесткой критике. Другие вспомнили, что ранее компания не раз вступала в конфликты с американским властями, резко отказываясь помогать во взломе своих устройств и внедрять бэкдоры в свои продукты. Третьи напротив говорят о том, что Apple вовсе не непогрешима, и, например, в Китае вынуждена во многом уступать и помогать правительству ради ведения бизнеса.